Für ESXi 7.0 GA wurde am 23. Juni 2020 ein Patch veröffentlicht, der einige Sicherheitskorrekturen und Bugfixes mit sich bringt. Die Version wird damit von ESXi 7.0 GA auf ESXi 7.0b angehoben.

Üblicherweise aktualisiere ich die Hosts in meinem Homelab sehr zeitnah. Da alle Hosts im Einklang mit der HCL sind, entschied ich mich für ein vollautomatisiertes Update durch den vSphere Lifcycle Manager (vLCM).

Die Spezifikation

| Server | SuperMicro SYS-E300-9D-8CN8TP |

| BIOS | 1.3 |

| ESXi | 7.0 GA build 15843807 (zuvor) / 7.0b build 16324942 (danach) |

| HCL | ja |

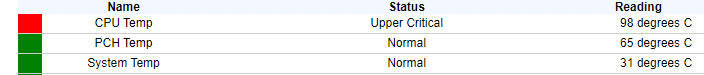

Nach dem ersten Host-Neustart bemerkte ich eine Warnleuchte am Servergehäuse und auch die Lüfter drehten mit maximaler Geschwindigkeit (was nicht zu überhören ist). Ein kurzer Blick ins IPMI zeigte, dass die CPU Temperatur einen kritischen Wert erreicht hatte.

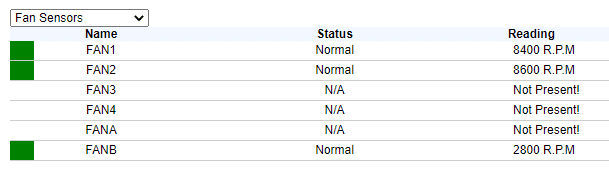

Wie man im Screenshot erkennen kann, ist die Gehäusetemperatur moderat und die Lüfter drehen bei diesen Bedingugen normalerweise mit geringer bis mittlerer Drehzahl. Die Temperatur der Ansaugluft betrug 25°C. Im Bild unten kann man sehen, dass nur Lüfter 1+2, welche für die Kühlung der CPU verantwortlich sind am Maximum arbeiten. Lüfter B, der PCI und LAN Komponenten kühlt, dreht weiterhin mit niedriger Leistung.

Meine ESXi Knoten starteteten nach dem Update korrekt mit der neuen Buildnummer 16324942 und es gab keine Fehlermeldungen im vLCM. Man konnte jedoch deutlich hören, dass etwas nicht in Ordnung war. Ein 4cm Gehäuselüfter der am Maximum dreht, teilt einem das unmissverständlich mit. Auffallend war ausserdem, dass der Bootvorgang deutlich länger dauerte als üblich.

Ich habe den Cluster schnellstens herunter gefahren, um eine Kernschmelze in der CPU zu vermeiden.

„Ungewöhnliches CPU Problem nach Update auf ESXi 7.0b“ weiterlesen